https://arxiv.org/abs/2407.07464

Video-to-Audio Generation with Hidden Alignment

Generating semantically and temporally aligned audio content in accordance with video input has become a focal point for researchers, particularly following the remarkable breakthrough in text-to-video generation. In this work, we aim to offer insights int

arxiv.org

해당 논문을 보고 작성했습니다.

Abstract

input video와 의미적으로, 시간적으로 align 된 audio content를 생성하는 것은 많은 관심을 받고 있습니다. 이 논문에서 저자들은 vision encoder, auxiliary embedding, data augmentation technique이라는 세 가지 중요한 측면에 중점을 두고 video-to-audio generation paradigm에 대한 insight를 제공하고자 합니다. 간단하지만 매우 효과적인 직관을 기반으로 하는 기초적인 model인 VTA-LDM에서 시작하여 다양한 vision enocder, auxiliary embbedding에 대한 연구를 진행합니다. generation quality와 video-audio synchronization alignment를 강조하는 포괄적인 평가 pipeline을 사용하여 저자들의 model이 video-to-audio generation에 있어 가장 좋은 성능을 보여준다는 것을 증명합니다. 그리고 저자들은 다양한 data augmentation method가 generation framework의 전체 성능 향상에 대한 영향을 끼친다는 것에 대한 직관을 제공했습니다.

Introduction

저자들의 목표는 주어진 silent video와 의미적으로, 시간적으로 align 된 audio content를 생성하는 것입니다. baseline model들은 주로 non-autoregressive generation framework를 사용하며, 특히 Latent Diffusion Model (LDM)을 주로 사용합니다. 이러한 model들은 textual or visual feature를 generative condition으로 사용하여 audio content를 생성합니다. 하지만 video to audio와 text to audio 간의 구별은 두 가지 주요 과제를 제시합니다. input condition과 의미적 일관성을 확보해야 하고, video와 생성된 audio 사이 시간적 alignment를 보장해야 합니다.

저자들은 3가지 측면(vision encoder, auxiliary embedding, data augmentation)에 초점을 맞춰 VTA training paradigm에 대한 insight를 제공하려 합니다. vision encoder는 input video로부터 visual feature를 추출하고 해석하여 관련된 audio content를 생성하는 데 중요한 visual pattern을 capture합니다. 그리고 temporal information 또한 encode 할 가능성이 있습니다. auxiliary embedding은 model에 추가적인 contextual information을 제공하는 중요한 source입니다. 예를 들어 textual description, positional embedding 또는 video와 관련된 다른 metadata가 있습니다. data augmentation은 training data의 variation과 perturbation을 도입함으로써, model의 일반화 성능을 향상시켜 줍니다. 특히, training data의 time-stretching은 빠르게 변화하는 video scene을 생성할 수 있으며, 이를 통해 model이 visual and auditory information 사이 시간적 관계를 이해하고 학습할 수 있도록 도와줍니다.

저자들의 연구는 기초저인 VTA model인 VTA-LDM을 학습하는 것을 시작으로 합니다. clip 기반 vision encoder를 사용하여 저자들은 frame-level video feature를 시간적으로 concatenate하고 projector를 사용하여 condition으로 mapping 합니다. VTA-LDM의 전체 framework는 다음과 같습니다.

저자들은 두 주요한 측면인 semantic alignment와 temporal alignment에 집중하여 model을 평가했습니다. semantic alignment는 생성된 output의 의미적 일관성과 audio 관련성을 평가하며, temporal alignment는 생성된 audio와 그에 대응하는 video frame 사이 synchronization을 측정합니다. 저자들은 전체 성능에 영향을 줄 수 있는 3가지 key factor에 대한 영향을 조사하기 위해 포괄적인 ablation 실험을 진행했습니다. 실험 결과를 통해, 저자들의 framework가 다른 basic framework보다 TTA task 성능이 뛰어나다는 것을 보였으며, visual input과 의미적으로 align 되고 부분적 temporally align 된 audio를 생성할 수 있음을 보였습니다. 그리고 추가적인 feature를 framework에 적용하는 것이 생성 quality를 크게 향상시키고 audio와 visual element의 synchronization 성능도 크게 향상시킨다는 것을 확인했습니다. 예를 들어 추가적인 textual prompt를 포함하는 것이 의미적 이해를 도울 수 있으며, pretraining이 생성 quality를 크게 향상시킵니다. 요약하자면 저자들의 key contribution은 다음과 같습니다.

- 저자들은 VTA-LDM이라는 효율적인 VTA framework를 제안하며, VTA task에서 SOTA 성능을 달성했습니다.

- 저자들은 VTA paradigm에 있는 vision encoder, auxiliary embedding, data augmentation이라는 세 가지 측면에 대해 연구를 진행했습니다.

- 포괄적인 평가를 통해, 저자들은 model의 design과 학습 과정에 대한 가치있는 insight를 제안합니다.

Baseline Framework

Overall Framework

이전 TTA 연구와 multi-modal 연구에서 영감을 받아, 저자들은 기초적인 VTA framework인 VTA-LDM을 개발했습니다. 이는 vision encoder, conditional LDM, mel-spectrogram/audio variational auto-encoder (VAE)라는 주요 component로 구성됩니다. 구체적으로 저자들은 pre-trained vision encoder에서 vision feature를 추출하고 LDM의 generation condition으로 feed 합니다. 이때 linear projection layer를 사용하여 condition을 생성합니다. LDM은 mel-spectrogram의 latent audio representation에서 연산을 수행합니다. pre-trained audio VAE는 denoised latent output을 decoding 하여 mel-spectrogram을 얻으며, 마지막으로 vocoder를 사용하여 final audio를 생성합니다.

Vision Encoder

Vision Encoder는 video V의 semantic meaning 뿐만 아니라 생성된 audio와의 align에 필요한 temporal information을 encoding합니다. 저자들은 CLIP4CLIP과 같은 pre-trained vision encoder f_v를 사용하여 input video에서 visual feature를 추출했습니다. 이러한 feature들은 객체, 동작, scene context를 포함한 필수적인 visual information을 capture 합니다. 저자들은 projection layer를 사용하여 이 feature들을 diffusion condition의 차원으로 mapping 했습니다. vision encoder는 학습 과정에서 frozen 되지만, projection layer는 학습됩니다.

Latent Diffusion Model (LDM)

original input x_0가 주어졌을 때, diffusion model은 점진적으로 random noise를 더해 Gaussian distribution으로 변환합니다. model은 original input data를 복원하기 위해 reverse denoising process를 학습합니다. 연산 효율성을 위해, LDM은 input x를 저차원 latent space Z로 encode 하는 학습된 perceptual compression model을 통합합니다. text-based generation task에서, generation condition은 text description입니다. VTA 실험에서는 projected video feature를 condition으로 사용합니다.

저자들은 denoising을 수행하기 위해, noise를 예측하는 ε_θ network를 학습합니다. condition C = Φ(f_V)은 input video의 projected visual embedding입니다. 저자들은 classifier-free generation approach를 사용했습니다. latent variable이랑 textual prompt가 주어졌을 때, generation은 conditionally and unconditionally 모두 수행합니다.

위 식에서 ∅는 null text embedding을 나타내고, w는 guidance scale입니다. text-based generation의 경우 Φ("")을 사용하여 null condition을 사용하며, TTA task에서도 null visual condition을 사용합니다.

Audio VAE and Vocoder

audio source는 먼저 Short-Time Fourier Transform (STFT)를 사용하여 mel-spectrogram으로 변환하고, 그 후 pre-trained audio VAE를 사용하여 latent representation z로 변환합니다. 저자들은 AudioLDM의 pre-trained VAE를 사용합니다. reverse process에서는 Hifi-GAN vocoder를 사용하여 latent z로부터 audio를 복원합니다.

Experimental Setup

Dataset

저자들의 주요 실험은 VGGSound를 가지고 수행되며, 이는 acoustic visual-audio event pair가 있는 550시간 video로 구성됩니다. 저자들은 200k video를 가지고 model을 학습하고 3k video를 가지고 평가를 진행했습니다. 특정 ablation의 경우, 저자들은 original dataset을 random하게 자르고 결합하는 방식으로 augmented training set을 만들거나, 대규모 unlabelled audio 또는 video corpora를 사용했습니다.

Objective Evaluation

정량적 평가로 주로 사용되는 metric들을 objective evaluation으로 사용했습니다. semantic consistency을 평가하기 위해 Frechet distance (FD), Frechet audio distance (FAD), Inception Score (IS), Kullback-Leibler (KL)을 사용하여 ground truth와 생성된 audio 사이 의미적 유사도를 측정했으며, audio의 다양성과 quality를 평가했습니다. contrastive language-audio pretraining (CLAP) score는 생성된 audio가 audio의 text description과 얼마나 잘 align 되는지 측정합니다. temporal alignment를 측정하기 위해, input video와 생성된 audio가 align 되었는지 평가하는 AV-Align을 사용했습니다. CAVP는 audio가 visual input 하고 의미적으로, 시간적으로 얼마나 잘 align 되었는지 평가합니다. 뿐만 아니라 Prompting Audio-Language Models (PAM)을 사용하여 생성된 audio의 quality를 평가했습니다.

Subjective Evaluation

저자들의 model에 대한 subjective evaluation을 위해, 저자들은 전체 quality, audio quality, video-audio semantic alignment, video-audio temporal alignment를 1 to 100 scale로 평가를 진행했습니다.

Experiments

Basic Configs

저자들의 LDM 구조는 2048차원 cross-attention과 input 및 output channel을 8로 설정했습니다. 저자들은 warmup step으로 300번 model을 학습하고, learning rate로 6e-5로 설정했으며, batch size도 128로 설정했습니다. 모든 model은 총 120 epoch 만큼 학습을 진행했습니다. inference할 땐, 저자들은 300번 denoise step을 진행하고 audio 당 1개씩 sample을 생성했습니다. 그리고 guidance scale을 3으로 설정해 classifier-free guidance를 진행했습니다.

Initial Results

저자들은 저자들의 model을 다른 VTA baseline과 비교를 진행했습니다. 구체적으로 다음 open-source baseline을 사용했습니다.

- IM2WAV는 image나 image sequence를 기반으로 audio를 생성하는 open-domain audio generation system입니다. model은 low-level audio representation을 생성하기 위해 language model을 사용했습니다. 저자들은 default parameter를 사용하여 pre-trained checkpoint baseline을 사용했습니다.

- Diff-Foley는 CAVP로 feature를 추출하여 사용하는 LDM model입니다. CAVP는 contrastively pre-trained encoder이며, temporally and semantically aligned audio-visual feature를 학습합니다. 저자들은 pre-trained Diff-Foley를 baseline으로 사용했습니다.

- Seeing&Hearing은 pre-trained ImageBind model을 사용하여 multimodality latent aligner를 만들었습니다. 이 역시 LDM을 generation framework로 사용했습니다.

- T2AV는 visual-aligned text embedding을 condition으로 사용하는 diffusion-based audio generation system입니다. 다른 baseline과 비교했을 때, T2AV generation은 textual description 기반입니다. model은 pre-trained video-audio CLAP (VA-CLAP)을 vision encoder로 사용합니다.

다른 vision encoder (VE)를 사용하는 VTA baseline과 저자들의 model 성능을 평가한 결과가 위와 같습니다. 저자들의 model이 모든 metric에서 다른 baseline보다 뛰어난 성능을 보여주고 high-quality, diverse and temporally-aligned audio를 생성합니다. 구체적으로 저자들의 model은 IM2WAV와 Diff-Foley보다 낮은 FAD, FD를 달성하며, ground truth audio와 generated audio의 분포가 더 비슷합니다. CLAP, CAVP, AV-Align에 대해, 저자들의 model이 baseline보다 훨씬 뛰어난 성능을 보여주며 의미적으로 관련 있고 시간적으로 algin 된 audio를 생성할 수 있음을 알 수 있습니다.

Experiments on Vision Encoders

제안한 generation framework를 기반으로, 저자들은 다양한 vision encoder를 사용하여 ablation 실험을 진행했습니다.

- Clip4Clip은 pre-trained Contrastive Language-Image Pre-training (CLIP) model 기반 video-text retrieval에 초점을 둡니다. 실험을 통해 CLIP은 frame level의 video input에서 knowledge를 추출하는 backbone으로 사용할 수 있음을 보였습니다. 저자들은 similar linear projection을 사용하여 CLIP에서 추출한 frame-level video feature를 generation condition으로 mapping 했습니다.

- Imagebind는 image, text, audio를 포함하는 공통 embedding을 학습하기 위해 다양한 modality에 대해 pre-train 되었습니다. 모든 modality는 image pair 된 data로 연결됩니다. 저자들은 input video에서 추출된 frame에 대해서 추출된 image embedding을 얻기 위해 Imagebind를 사용합니다.

- LanguageBind는 Imagebind와 유사하게 학습되지만, 다른 modality와의 연결점으로 language를 사용합니다. language는 많이 연구된 modality이며 TTA 연구의 condition으로 효과적이라는 것이 입증된 바와 같이, LanguageBind에서 추출한 vision embedding이 더 나은 조건으로 작용할 수 있는지 확인하고자 사용했습니다.

- V-JEPA는 I-JEPA의 확장된 version으로, video를 self-supervised learning 합니다. I-JEPA는 semantic image feature를 학습할 수 있으며, 여기서 발전된 V-JEPA는 video understanding을 위한 spatial-temporal way로 video representation을 학습합니다.

- ViViT는 pure-transformer 기반 model입니다. model이 video classification을 위해 design 되었음에도 불구하고, 저자들은 input video로부터 학습된 spatio-temporal token이 audio 생성에 guide를 할 수 있는지 아닌지 확인하기 위해 사용했습니다.

- CAVP는 semantic contrast loss와 temporal contrast loss 둘 다 사용하여 학습되며, audio-video feature의 semantic and temporal alignment를 향상했습니다. synchronized video-conditioned content를 합성하기 위해 DIFF-FOLEY model이 사용했던 CAVP를 사용했습니다. 저자들은 pre-trained CAVP을 vision encoder로 사용했습니다.

실험 결과는 위와 같습니다. vision encoder를 선택하는 것이 input video로부터 semantic and temporal information을 capture 하는 것에 있어 중요한 역할을 합니다. 그리고 vision encoder를 선택하는 것이 생성된 audio의 quality, diversity, alignment에 직접적인 영향을 끼칩니다. 실험을 통해, pre-trained Clip model을 기반으로 하는 Clip4Clip이 high-quality, diverse semantically-related audio content를 생성할 수 있다는 것을 볼 수 있습니다. ViViT과 V-JPEA처럼 다른 vision encoder를 사용하는 method들이 대부분의 metric에서 더 낮은 성능을 보여줍니다. AV-Align을 통해 CAVP가 temporal alignment가 잘 수행되는 것을 볼 수 있습니다.

Experiments on Auxiliary Embeddings

저자들은 visual feature를 넘어선 auxiliary embedding이 생성 과정을 향상시킬 수 있는지 탐구합니다. 많은 연구들이 추가적인 정보가 다양항 방식으로 생성 결과를 향상시킬 수 있다는 것을 입증했습니다. 저자들은 여러 auxiliary embedding을 사용하여 이러한 현상에 대해 조사합니다.

- Text Information: 추가적인 textual label은 visual feature에서 즉시 식별할 수 없는 valuable context를 제공할 수 있으며 추가적인 semantic detail을 제공할 수 있습니다. 게다가 text information은 video의 불필요한 정보를 걸러내는 데 도움을 줄 수 있습니다. 예를 들어 video에서 총이 등장한다고 해서 반드시 그에 대응하는 audio가 생성되는 것은 아닙니다. 저자들은 실험을 통해, text embedding을 얻기 위해 CLIP을 사용하여 이를 video embedding에 concatenate 하여 condition으로 사용했습니다.

- Positional Embedding: positional embedding은 시간적 순서나 sequence를 부여하기 때문에 audio generation에 있어 매우 중요합니다. 특히 vision encoder가 주로 audio의 semantic에 초점을 맞추고 있을 때는 필수적입니다. 직관적으로 position embedding은 model이 event sequence를 이해할 수 있도록 도와주며, 일관성 있는 audio를 생성할 수 있게 만들어줍니다. 저자들은 Transformer model에서 사용하는 method와 유사하게 sinusoidla positional embedding을 사용했으며, 이는 상대적 위치를 쉽게 attention 할 수 있게 만들어 줍니다.

- Optical Flow: Optical flow는 video sequence에 있는 motion and dynamic 특성에 대한 insight를 제공합니다. 이전 연구에서는 video 내의 sound source를 localizing 할 수 있는 정보를 제공했습니다. 저자들은 optical flow video embedding을 추가적인 condition으로 사용하여 generation을 수행합니다. 이전 embedding들과 유사하게, 이 embedding을 original video embedding과 concatenate하여 풍부한 input representation과 audio generation process의 잠재적 발전을 기대했습니다.

결과는 위와 같습니다. 저자들은 위 결과를 통해 extra text embedding과 extra positional embedding과 같은 auxiliary embedding의 효과를 확인했습니다. 추가적인 정보는 input data에 대한 model의 이해도를 향상시킬 수 있고 생성된 audio의 quality도 향상시킬 수 있습니다. 추가적인 text embedding을 더하는 것인 Inception Score (IS)를 상승시키고 FAD, FD, KL을 감소시키며, text로부터 추가적인 semantic information이 quality를 향상시키고 생성된 audio의 다양성을 향상시킬 수 있다는 것을 의미합니다. 반면에 추가적인 position embeddings (PE)을 사용하는 것은 혼합된 효과를 보였습니다. text embedding과 position embedding을 결합하는 것이 가장 높은 IS score를 달성했지만, FAD가 증가되고 AV-Align score가 감소되었습니다. 결합된 embedding이 생성된 audio의 다양성을 향상시킬 순 있지만, 반드시 ground-truth audio와의 alignment를 향상시키는 것은 아니라는 걸 보여줍니다.

Experiments on Data Augmentation

training set의 data quality가 부인하기 어려울 정도로 model 성능에 크게 영향을 미치며, 특히 large generative model을 학습할 때 더욱 그렇습니다. 저자들은 세 가지 다른 관점에서 data augmentation을 탐구했습니다.

- Data Clean: data clean은 input data의 정확성, 일관성, 오류나 이상이 없는 걸 나타냅니다. 저자들은 CLAP model을 사용하여 extrac textual label (score > 0.3)을 기반으로 비슷한 의미를 가진 audio-video pair를 선택하였습니다. 그리고 저자들은 AV-Align score를 사용하여 unmatched video-audio pair (score > 0.2)를 filtering 했습니다. VGGSound dataset의 경우, 저자들은 100k high-quality video-audio pair를 filtering했습니다.

- Concat Augmnent: original VGGSound dataset은 주로 single audio event를 포함하는 audio clip으로 구성되어 있습니다. 이는 dataset이 clean 하지만, model이 복잡한 video에서 시간적 information을 다룰 수 있는 능력을 평가할 수 없습니다. 학습할 때 다양한 audio event를 가지고 복잡한 generation task를 시뮬레이션하기 위해, 저자들은 서로 다른 audio event에 대한 서로 다른 두 video를 random 하게 concatenate 합니다.

- Pretrain: 저자들은 pretraining 성능을 활용해 보았습니다. 저자들의 model을 2개 다른 data corpus에서 pretrain 했습니다. YouTube에서 추출한 10k 시간의 대규모 video-audio corpus와 WavCaps, YouTube에서 가져온 150k 시간 분량의 audio corpus를 사용했습니다. YouTube corpus는 VGGSound video data와 동일한 방식으로 처리되었습니다. 저자들은 talking and music content를 거르고, audio event case만 사용하여 학습했습니다. video-audio pretraining의 경우, video-to-audio supervised 학습을 사용했습니다. audio pretraining의 경우, 저자들은 audio self-supervised 학습을 수행했습니다. 이후, 저자들이 original training set으로 model의 모든 parameter를 finetuning 했습니다.

다양한 data augmentation method에 대한 video-to-audio generation model 성능 결과는 위와 같습니다. 저자들은 data augmentation 없이 baseline model을 사용한 것과 다양한 data augmentation method를 사용한 model을 비교했습니다. Data Clean이 가장 큰 성능 향상을 보였습니다. noisy or irrelevent video-audio sample을 제거하는 것이 audio quality와 video-audio alignment를 향상시켰습니다. Concat Augment는 IS 성능을 향상시켰으며, 이 방법이 생성된 audio content의 다양성을 높일 수 있음을 시사하며 AV-Align에서의 큰 향상도 보여주어 video-audio alignment가 개선되었음을 나타냅니다. 하지만 FAD, KL과 같이 distance metric은 data augmentation method를 사용했을 때 약간 감소합니다. data corpus 내 data augmentation이 다양성과 alignment를 향상시킬 수 있지만, audio content 자체와 관련하여 trade-off가 있을 수 있습니다. extra data를 가지고 pretraining하는 것은 이러한 문제를 해결하는 데 도움이 될 수 있습니다. 위 결과를 보면 extra unlabelled video and audio data로 pretraining하는 것이 생성 metric을 향상시킴을 보여줍니다. 저자들은 이러한 augmentation method를 적절히 결합하는 것이 VTA task의 전반적 성능을 향상시킬 수 있다고 믿습니다.

Further Experiments & Discussion

Subjective Evaluation

저자들은 ablation model에 관한 subjective evaluation을 수행했습니다. 결과는 위와 같습니다. 각 20개 video-audio pair를 선택하여 측정했습니다.

전반적으로 참가자들의 subjective evaluation이 objective evaluation과 일치하는 경향이 있으며, 저자들의 framework가 다른 baseline보다 뛰어남을 보여줍니다. 하지만 자연스럽고 사실 같은 audio 수준까지 성능을 올릴 여지가 남아 있다고 합니다. 각 지표를 세부적으로 살펴보면, VTA-LDM + Text + Concat model이 ablation model들 중 가장 좋은 성능을 보였으며, 다른 baseline들도 능가하는 모습을 보였습니다. 즉 auxiliary embedding과 data augmentation technique을 결합하는 것이 효과적임을 볼 수 있습니다. 특히 semantic and temporal alignment의 개선을 위해선 video-to-audio training paradigm에 이러한 요소들을 통합하는 것이 중요하다는 것을 강조합니다.

또한 대부분의 baseline이 상당한 변동성을 나타낸다는 점도 주목할 점입니다. 생성된 사례들을 추가로 검토한 결과, 저자들은 model이 video scene의 복잡성이나 여러 audio source의 존재와 같은 특정 요인에 민감하게 반응한다는 것을 발견했습니다. 결과적으로 현재 존재하는 VTA model들의 성능이 ground-truth보다 어떠한 관점에서도 눈에 띄는 격차를 보인다고 합니다.

Overall Discussion

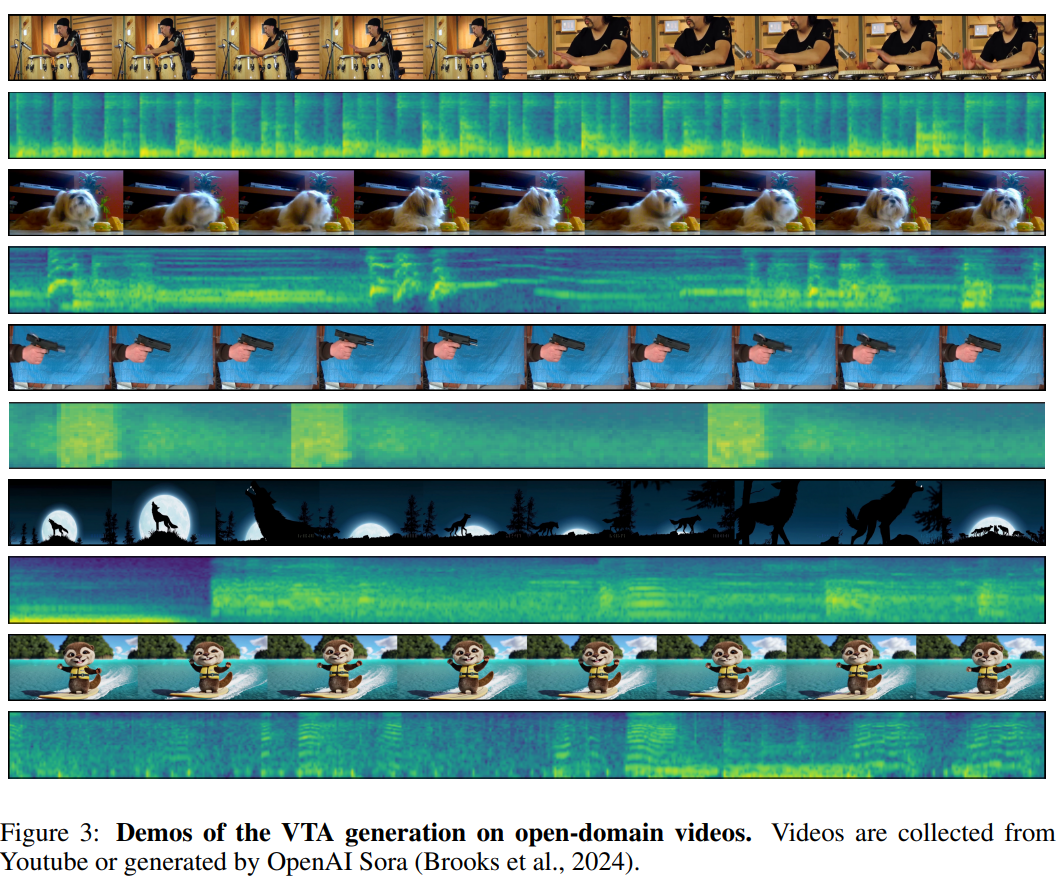

TTA demo는 위와 같습니다. 정량적 평가를 기반으로, 저자들의 vanilla structure는 TTA task의 semantic alignment 문제를 효과적으로 해결할 수 있는 능력을 입증했습니다. vanilla structure의 design이 text prompt에서 semantic information을 capture 하고 generated audio content로 변환할 수 있으며, 결과적으로 high-quality semantically aligned audio를 생성할 수 있습니다.

하지만 vanilla structure는 TTA task의 temporal alignment 문제를 해결할 가능성을 보이지만, 부분적으로 이 문제를 해결합니다. 생성된 audio event가 그에 대응하는 video의 visual event와 align 하는 temporal alignment는 더 복잡한 문제이며 추가적인 고려 사항이 필요로 합니다. 저자들은 position encoding, data augmentation과 같은 추가적인 방법을 사용하여 전체적인 성능을 향상시킬 수 있음을 보였습니다. position encoding은 model이 venet의 temporal order를 이해할 수 있게 도와주고, 생성된 audio content의 temporal alignment를 향상시켜줍니다. 반면에 data augmentation은 더 다양하고 복잡한 data scenario를 통해 model의 일반화 성능을 향상시킬 수 있습니다. 이러한 방식들이 일반적으로 semantic and temporal alignment를 향상시킬 수 있지만, 때때로 negative feedback을 제공할 때도 있습니다. table 3, 4를 보면 확인할 수 있습니다.

위 그림은 저자들의 model이 여러 복잡한 scenario에서 대응하는 temporally aligned audio를 생성할 수 있음을 보여줍니다. 하지만 model이 scene 변화를 놓치는 경우도 있습니다. 저자들의 관점에서 보면, 이전에는 무시했던 여러 key problem은 현재 기술로는 해결하지 못했습니다. 1) video에 존재하는 객체가 존재한다고 해서 반드시 소리를 내는 것은 아닙니다. 몇몇 객체들은 context나 행동에 따라 다른 소리를 생성할 수 있으며, video에 있는 모든 객체가 소리를 만드는 것은 아닙니다. model은 이러한 video에 있는 silent object를 인지하지 못합니다. 그럼에도 불구하고, 저자들의 model은 open-domain task에서 robust 하게 생성하는 능력을 보여주며, silent YouTube 또는 AI-generated video로부터 자연스럽고 사실 같은 audio를 생성할 수 있습니다. 아래 그림을 통해 확인할 수 있습니다.

Conclusion

이 논문에서 저자들은 VTA task에 대해 탐구했으며, 주어진 silent video piece에 맞춰 semantically-related and temporally-aligned audio를 생성하는 것을 목표로 합니다. VTA model의 diffusion-based backbone을 사용하여 저자들의 VTA-LDM framework의 효과를 입증하였고, model 설계와 학습 과정에서 다양한 ablation 실험을 수행했습니다.

이 논문에서 제안하는 model은 제한된 dataset인 VGGSound로 학습했습니다. data augmentation과 YouTube test set을 filtering 하여 나온 결과를 사용했지만, 여전히 성능 향상할 여지가 남아있습니다.